محتويات المقال

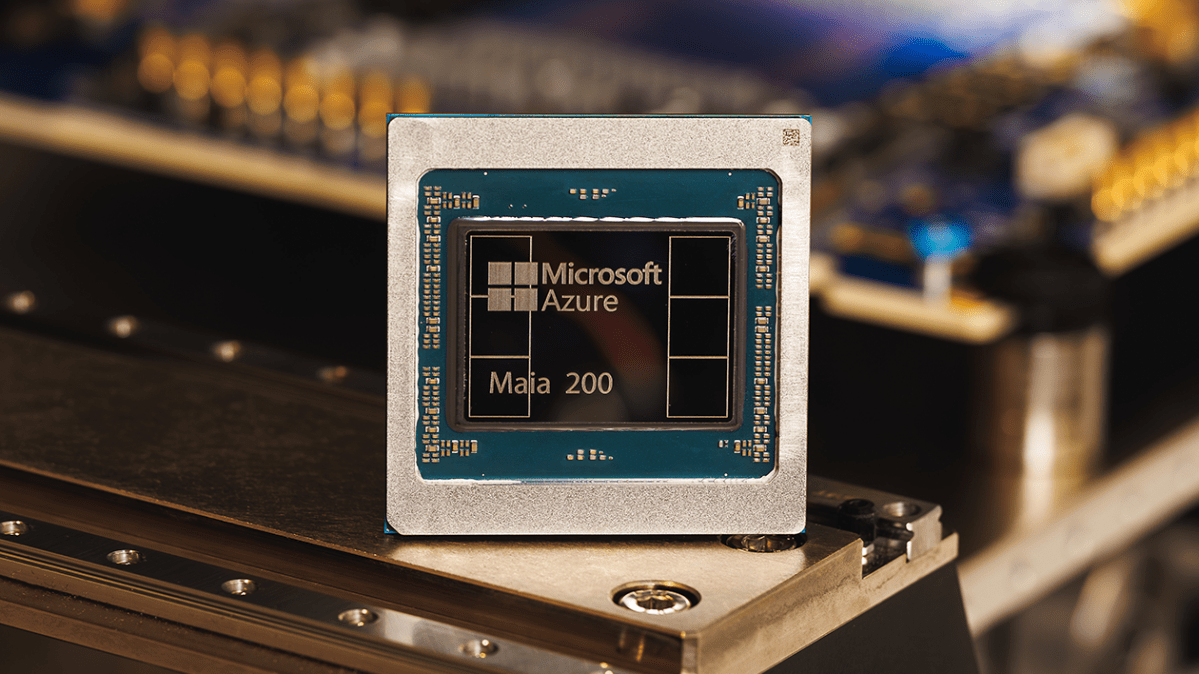

مايكروسوفت تطلق مايا 200: تحول في استدلال الذكاء الاصطناعي

في 26 يناير 2026، أعلنت مايكروسوفت عن شريحة Maia 200، أحدث إنجازاتها في مجال رقائق الذكاء الاصطناعي، ووصفتها بأنها "حصان عمل سيليكوني" لتوسيع نطاق الاستدلال. تأتي هذه الشريحة خلفاً لـMaia 100 الصادرة عام 2023، وتحتوي على أكثر من 100 مليار ترانزستور، توفر أداءً يفوق 10 بيتابلوبس بدقة 4 بت، ونحو 5 بيتابلوبس بدقة 8 بتقفزة هائلة في السرعة والكفاءة.

أهمية الاستدلال في اقتصاد الذكاء الاصطناعي

الاستدلالعملية تشغيل نماذج الذكاء الاصطناعي المدربةيسيطر الآن على تكاليف التشغيل لشركات الذكاء الاصطناعي مع نضوج النماذج. بخلاف التدريب، يعمل الاستدلال باستمرار على استفسارات المستخدمين، مما يرفع النفقات. تقول مايكروسوفت إن عقدة واحدة من Maia 200 تستطيع تشغيل أكبر النماذج الحالية مع مساحة للنماذج الأكبر مستقبلاً، مما يقلل التعطيلات واستهلاك الطاقة.

التأثير السوقي: كسر قبضة إنفيديا

يعزز الإعلان المنافسة بين عمالقة التكنولوجيا في تطوير رقائق مخصصة للابتعاد عن هيمنة Nvidia. بطاقات Nvidia الرسومية لا تزال أساسية، لكن نقص التوريد وارتفاع التكاليف يدفعان للبدائل. توفر Google وحدات TPU قوة حوسبة سحابية، بينما أطلقت Amazon Trainium3 في ديسمبر 2025 لتحسينات مشابهة. تندمج Maia 200 مع نظام Azure، وقد تخفض تكاليف الاستدلال بنسبة 20-30% للعملاء الذين يشغلون نماذج لغة كبيرة.

- المواصفات التقنية: أكثر من 10 بيتابلوبس (4 بت)، 5 بيتابلوبس (8 بت)، مُحسَّنة لمهام الذكاء الاصطناعي الآنية.

- توفير الطاقة: تقليل استهلاك الطاقة يتيح مراكز بيانات أكثر كثافة وتكاليف تشغيل أقل.

- التوسع في النشر: مصممة لـAzure، تدعم خدمات الذكاء الاصطناعي واسعة النطاق مثل Copilot.

بالنسبة للشركات، يعني ذلك نشراً أرخص للذكاء الاصطناعي. مزود سحابي يستخدم Maia 200 يمكنه خدمة ضعف الاستفسارات لكل واط مقارنة بـNvidia H100، حسب معايير مايكروسوفت. يتوقع المحللون خفضاً بمليارات الدولارات في إنفاق البنية التحتية للذكاء الاصطناعي عالمياً بحلول 2027.

دلالات للمستثمرين والمنافسة

يرصد متابعو الأسهم دفعة مايكروسوفت نحو الأجهزة لتعزيز تفوق Azure على AWS وGoogle Cloud. قيمة سوق Nvidia القريبة من 3 تريليون دولار تواجه ضغوطاً مع اعتماد العملاء مثل مايكروسوفت على تصاميم داخلية. تقييم Ricursive بـ4 مليارات دولار لأدوات تصميم رقائق ذكاء اصطناعي يعكس رهانات المستثمرين على هذا التحول.

يأتي نشر Maia 200 مع ارتفاع طلب الاستدلالChatGPT من OpenAI يتعامل مع 8.4 مليون استفسار علمي أسبوعياً. قد تنخفض تكلفة الاستعلام الواحد من سنتات إلى جزء من السنت، مما يفتح أبواب تطبيقات ذكاء اصطناعي جماهيرية في الرعاية الصحية والمالية والأنظمة الذاتية.

الآفاق المستقبلية: نحو ذكاء اصطناعي شامل

بحلول 2028، نتوقع مراكز بيانات هجينة تجمع تدريب Nvidia مع رقائق متخصصة في الاستدلال مثل Maia 200. هذا يُديمقرط الذكاء الاصطناعي، يمكّن الشركات الصغيرة من المنافسة. مقارنة نائب رئيس OpenAI كيفن ويل بـ2025 في هندسة البرمجيات تشير إلى تسريع سير العمل العلمي.

المخاطر قائمة: الرقائق المخصصة تربط المستخدمين بنظم مغلقة، وقدرة التصنيع في TSMC محدودة. لكن Maia 200 تضع مايكروسوفت لالتقاط 15-20% إضافي من حصة سوق السحابة للذكاء الاصطناعي، تعيد تشكيل اقتصاد استدلال يتجاوز 200 مليار دولار.

عقدة واحدة تشغل نماذج حدودية اليوم تُلمح إلى مجموعات إكسافلوب غداً، تدفع ذكاء اصطناعي وكيلي يتفكر عبر المجالات. حرب الرقائق تشتديجب على Nvidia الابتكار أسرع، أو تعيد عمالقة مثل مايكروسوفت تعريف بنية الذكاء الاصطناعي.